L’Intelligenza Artificiale è una disciplina dell’informatica che studia i fondamenti teorici, i metodi e le tecniche che consentono la progettazione di sistemi hardware e sistemi di programmi software in grado di simulare la capacità e il comportamento del pensiero umano. Questa disciplina negli ultimi anni sta giocando un ruolo sempre più importante nella Cybersecurity. Gli attacchi informatici stanno diventando sempre più complessi e pertanto è sempre più necessario sviluppare nuove tecnologie per gestire tale complessità. Ogni giorno le aziende elaborano grandi volumi di dati sugli eventi, record errati o duplicati e numerosi modelli di malware in migliaia di registri; quindi, il lavoro dell’analista della sicurezza è sempre più complesso e richiede l’aiuto dell’AI. Tuttavia, l’Intelligenza Artificiale può aiutare anche i cybercriminali a condurre attacchi molto più veloci ed efficienti.

L’Intelligenza Artificiale come scudo

L’Intelligenza Artificiale applicata alla Cybersecurity entra in gioco per individuare anomalie in tutti i dati raccolti ed esaminati. Le aziende di tutto il mondo sono impegnate nella ricerca di soluzioni per combattere e ridurre il cybercrimine. L’AI si sta rivelando la tecnologia migliore e più adatta a risolvere alcuni dei principali problemi nell’area della Cybersecurity. L’utilizzo dell’Intelligenza Artificiale e del Machine Learning per automatizzare l’individuazione delle minacce, consente di rispondere in maniera più efficace agli attacchi informatici di quanto non avvenga con i tradizionali approcci basati su software.

Nello specifico, l’AI aiuta le aziende durante le operazioni di Prevention e Detection degli incidenti di sicurezza. L’automazione consente alle aziende di distinguere tra comportamenti “benigni” e “criminali” attraverso modelli predittivi e utilizzo di dati storici. Questi modelli sono abbastanza intelligenti da rilevare e prevenire una moltitudine di minacce informatiche in tempo reale. Eliminando la necessità di un intervento manuale, le aziende possono focalizzarsi su altri processi che potrebbero richiedere maggiore attenzione. L’AI può anche utilizzare i dati degli attacchi informatici provenienti da più domini e settori in tutto il mondo per migliorare continuamente l’efficacia e i tassi di rilevamento.

Nello specifico, l’AI aiuta le aziende durante le operazioni di Prevention e Detection degli incidenti di sicurezza. L’automazione consente alle aziende di distinguere tra comportamenti “benigni” e “criminali” attraverso modelli predittivi e utilizzo di dati storici. Questi modelli sono abbastanza intelligenti da rilevare e prevenire una moltitudine di minacce informatiche in tempo reale. Eliminando la necessità di un intervento manuale, le aziende possono focalizzarsi su altri processi che potrebbero richiedere maggiore attenzione. L’AI può anche utilizzare i dati degli attacchi informatici provenienti da più domini e settori in tutto il mondo per migliorare continuamente l’efficacia e i tassi di rilevamento.

L’Intelligenza Artificiale come arma d’attacco

L’Intelligenza Artificiale può essere vista anche come un’arma, il cui effetto dipende da chi la tiene in mano ed a chi essa è rivolta. Grazie all’utilizzo di tecniche di penetrazione e analisi comportamentali, l’AI può aiutare anche i cybercriminali a effettuare e migliorare i loro attacchi. Nello specifico, l’AI può essere utilizzata dagli attaccanti per la ricerca di vulnerabilità informatiche, ovvero, esegue la scansione di più interfacce all’interno del sistema IT della vittima. Quando si verifica un “hit”, l’AI può distinguere se un attacco alla vulnerabilità è in grado d’impattare il sistema o se può semplicemente fungere da mezzo per inserire malware o codice dannoso nella rete. Può indovinare automaticamente le password attraverso l’apprendimento automatico. I criminali informatici possono utilizzano l’AI in connessione con il malware inviato tramite e-mail. Il malware può utilizzare l’AI per imitare il comportamento degli utenti. Gli assistenti d’intelligenza virtuale possono creare testi di qualità semantica così elevata che i destinatari trovano molto difficile distinguerli dalle e-mail reali. Infine, con l’aiuto dei sistemi d’Intelligenza Artificiale, le informazioni disponibili online possono essere estratte in modo più specifico per adattare siti web, collegamenti o e-mail, obiettivo di un attacco.

Artificial Intelligent wars

Come detto in precedenza, l’AI è un’arma e ha i suoi pro e contro in base a chi la utilizza. I cybercriminali la utilizzano per attaccare le aziende, mentre le aziende la utilizzano per difendersi, una specie di guerra tra AI.

Uno dei metodi che usa l’Intelligenza Artificiale attaccante per manipolare l’Intelligenza Artificiale che difende le aziende è il “data poisoning”, ovvero, “inquinamento dei dati”. Questa minaccia può avvenire in due modi:

- manipolando il set di dati utilizzato dall’Intelligenza Artificiale delle aziende;

- utilizzando tecniche di evasion, ovvero, manomettendo i dati di input forzando gli errori.

In entrambi i casi, con l’avvelenamento il set di dati è compromesso e quindi non sarebbe affidabile. Una soluzione sarebbe quella di controllare accuratamente i dati già presenti e in input, verificando che le fonti siano affidabili.

Un altro metodo è l’“inferenza”, ossia, che gli attaccanti riescano a decodificare i sistemi d’Intelligenza Artificiale da poter capire quali dati utilizza l’AI per l’apprendimento. Questa minaccia consente:

- l’accesso ai dati sensibili;

- spianare la strada al data poisoning;

- riprodurre il sistema d’Intelligenza Artificiale.

E questo è uno dei problemi più difficili da risolvere.

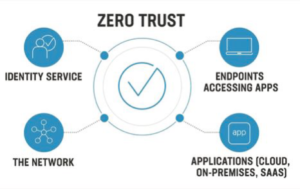

Le aziende per difendersi da questi attacchi stanno iniziando a combinare algoritmi di machine learning e la politica Zero Trust (considerando tutto dannoso tranne ciò che è esplicitamente considerato “buono”) garantendo la sola esecuzione di software autorizzati in precedenza. Questi algoritmi sono in grado di utilizzare pattern appresi per rilevare quando un processo in esecuzione cambia la sua modalità d’interazione con il sistema operativo e la rete, e sono in grado di prevenire e ripristinare lo stato normale del sistema. Questo approccio, quindi, blocca tutti i tipi di attacchi, anche gli attacchi zero-day, senza introdurre costi operativi eccessivi per le aziende.

I criminali informatici possono utilizzare l’Intelligenza Artificiale per supportare gli attacchi di ingegneria sociale. L’Intelligenza Artificiale può imparare a riconoscere i modelli comportamentali per convincere le persone via e-mail a intraprendere azioni rischiose o addirittura a consegnare informazioni sensibili. Una contromisura che potrebbe essere utilizzata per mitigare questo rischio include programmi di miglioramento continuo per addestrare il personale a difendersi dagli attacchi di ingegneria sociale attraverso simulazioni e sessioni di brainstorming.

Conclusioni

In un mondo in cui gli strumenti intelligenti sono sempre più utilizzati per scopi vitali e delicati, anche la possibilità teorica che gli hacker possano interromperne la funzionalità solleva molte preoccupazioni. L’AI rileva i rischi e automatizza le procedure di Cybersecurity, ma in realtà offre solo le basi per i processi decisionali umani. A un certo punto deve entrare in gioco l’intelligenza umana, che deve tenere conto anche delle implicazioni sociali ed economiche. In altre parole, l’AI aiuta a costruire conoscenze basate su regole e analisi rigorose, ma non copre aspetti altrettanto importanti come l’intuizione, la creatività, l’empatia o l’intelligenza umana. Non ci dobbiamo solo chiedere se siamo fiduciosi nel compiere un’azione al posto di un’altra, ma anche se ne vale la pena. I dati non possono essere protetti al 100% dall’Intelligenza Artificiale.

Come abbiamo visto, in un modo o in un altro, i cybercriminali potrebbero “prenderla in giro”. Infatti, la tutela dei dati personali e la sicurezza sono gli argomenti più discussi in questo ambito. L’AI può esaminare tutti i dati e proteggere il sistema dalle minacce o riparare il sistema se è stato danneggiato. Ma la sicurezza informatica deve essere realizzata con la collaborazione di uomini e macchine. In questa moderna guerra tra AI in ogni caso anche l’intelligenza umana deve arruolarsi! Solo insieme possono combattere gli attacchi informatici. Ci sono così tante possibilità che un sistema completamente AI non può gestire: nuovi attacchi, nuove vulnerabilità e persone che commettono errori.

L’intelligenza Artificiale è utile nella Cybersecurity se c’è un’attenta supervisione umana. Inoltre, visto che i Big Data e l’Intelligenza Artificiale avranno un ruolo sempre più centrale nella sicurezza informatica negli anni a venire, è necessario essere sempre aggiornati e all’avanguardia per poter mettere in atto una risposta adeguata alle minacce. L’Intelligenza Artificiale deve svilupparsi anche mettendo al centro l’etica, per garantire i nostri valori di giustizia, equità e sostenibilità. Concludendo, l’AI è costruita dall’uomo e di conseguenza deve essere l’uomo a porsi le domande per costruirla correttamente sotto il profilo dell’etica, della sicurezza e della privacy.

Autore: Rachele Genise